Science-赛博蜻蜓队长?AI在民主议事中的作用

这篇论文探讨了人工智能(AI)在民主讨论中促进共识的潜力,通过开发一个名为“哈贝马斯机器”的AI调解系统,帮助人们在复杂的社会和政治问题上达成共同立场。通过一系列实验,包括涉及超过5000名参与者的虚拟公民议会,研究表明AI调解比人工调解更有效,生成的群体声明更加清晰、公正,并能减少组内分歧。尽管AI调解展现了出色的潜力,研究也提醒在确保讨论的公平性和代表性时应谨慎。总之,AI调解为促进大规模民主讨论提供了一个高效且可扩展的解决方案。

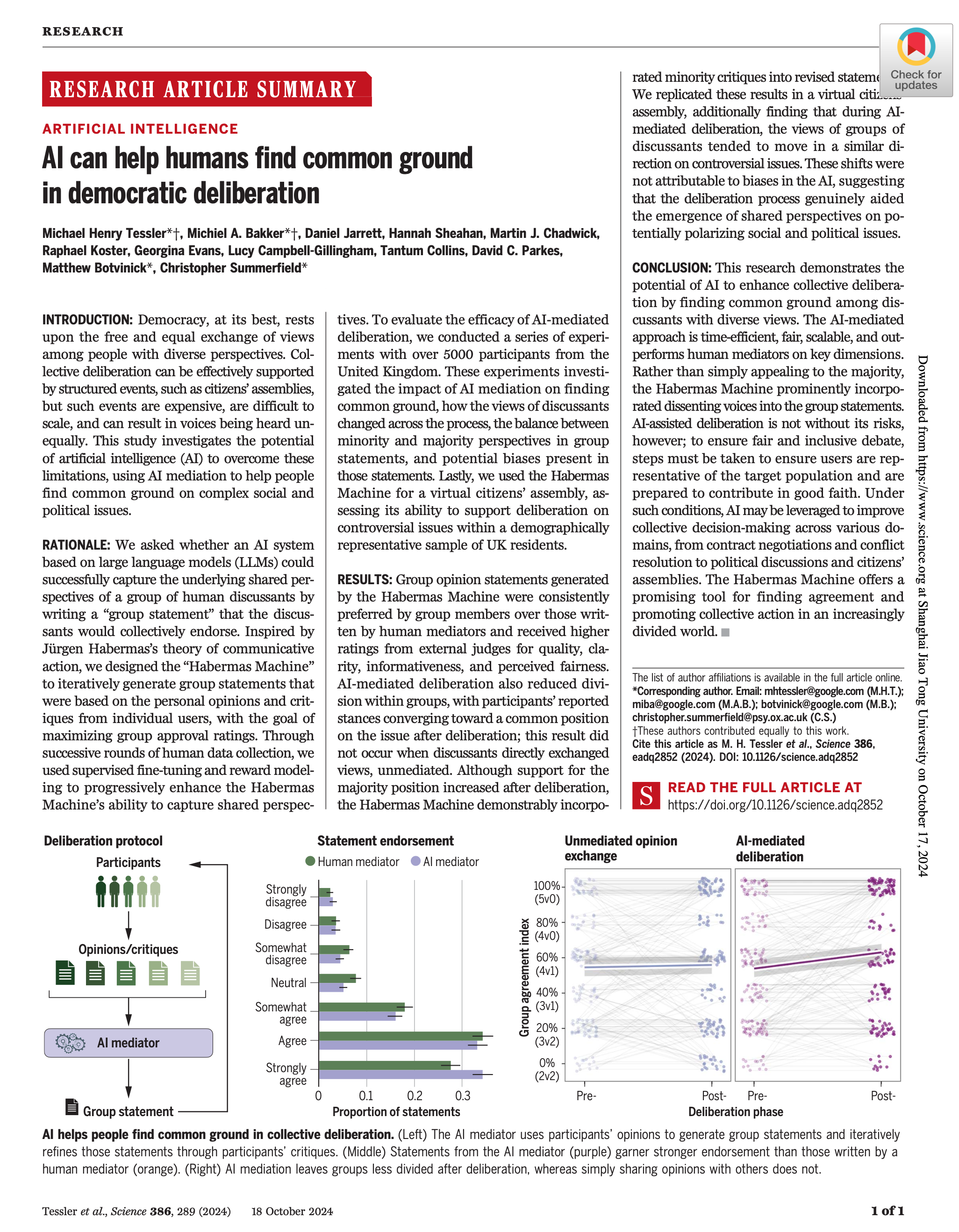

标题: AI can help humans find common ground in democratic deliberation

期刊: Science

作者:

- Michael Henry Tessler:共同一作。Research Scientist at Google DeepMind. Previously, he was a Postdoctoral Fellow working in the Department of Brain and Cognitive Sciences at MIT with Josh Tenenbaum and Roger Levy. He received my Ph.D. from the Department of Psychology at Stanford.

- Michiel A. Bakker:共同一作。Senior Research Scientist at DeepMind. He works on large language models and human-AI interaction. Before joining DeepMind fulltime early 2021, he was a Computer Science PhD student at MIT.

- Matthew Botvinick:共同通讯。Director of Neuroscience Research at DeepMind and Honorary Professor at the Gatsby Computational Neuroscience Unit at University College London. 他也是斯坦福大学Human-Centered Artificial Intelligence的一员。Fei-Fei Li🐮。在这篇Science论文里,他的书名单位还包括Yale Law School。

- Christopher Summerfield:共同通讯。Professor of Cognitive Neuroscience at the University of Oxford, and a Staff Research Scientist at Google DeepMind. His research group is well-known for its work on human perception, learning and decision-making.

发布时间: 18 October 2024

引言

寻求共识:方式与局限

人类社会因多样的合法观点而丰富,但要想集体行动,达成共识是前提条件。为了找到共识,人们通常通过面对面或在线的非正式或半结构化讨论,进行自由的意见交流。平等且开放的讨论是自由民主的基石,这种形式常常通过公民议会得到正式实现。在公民议会中,一些未经过选举的普通公民代表被随机选出,讨论一些有争议的问题。迄今为止,包括法国、加拿大和冰岛在内的几个国家已经通过大型公民议会来做出重要的国家政策决策。

然而,作为达成共识的一种方式,自由交换意见存在众所周知的局限性:

- 组织和参与成本高,耗时长;

- 讨论只能在小规模的群体中进行;

- 讨论过程中,声音可能无法得到平等表达,部分讨论者可能采取极端立场以增加影响力;

- 群体效应和社交压力可能导致观点固化。

相应地,研究显示,公民议会的效果各异,可能导致:

- 意见的同质化或两极化;

- 更好的或更差的决策质量;

- 政治参与的增加或减少。

AI作为调解工具的潜力

本文探讨了人工智能(AI)在克服这些限制方面的潜力。随着大语言模型(LLM)的发展,AI已被证明在生成公共讨论摘要、平衡各种政治观点等方面表现出色,能够提供更客观和公正的调解功能。因此,研究团队开发了一个AI系统“哈贝马斯机器”(Habermas Machine),以帮助参与者在讨论中找到共识。哈贝马斯机器的灵感来源于尤尔根·哈贝马斯的交往行为理论,该理论认为在理性的讨论下,公共领域的共识能够自然形成。

本文的研究目的是通过AI调解来帮助集体讨论,解决现有公民议会和其他民主讨论中存在的局限性。主要的研究问题包括:

- RQ1: AI调解能否帮助人们找到共识?

- RQ2: AI调解能否减少组内的分歧?

- RQ3: AI生成的声明能否平等地反映多数和少数意见?

- RQ4: AI调解能否在公民议会中应用?

交往行为理论

由德国哲学家尤尔根·哈贝马斯(Jürgen Habermas)提出的一个重要社会理论,旨在解释人类社会中的沟通与理解过程。该理论的核心是探讨人们如何通过语言交往达成共识,进而推动社会的理性化和民主化。

交往行为理论认为,人与人之间的沟通不仅仅是为了交换信息或表达个人意图,更重要的是,通过理性的对话,人们可以达成共识。这种共识不仅是临时的或权宜的,而是基于相互理解和认同的,能够促进社会的和谐与共同目标的实现。

哈贝马斯指出,理想的交往需要具备以下条件:

- 真实性:说话者必须诚实,表达的内容必须符合他们真正的想法;

- 正确性:沟通的内容应该是客观的,能够反映真实的世界状况;

- 合法性:沟通的内容应当符合社会的道德规范和规则;

- 可理解性:表达应该是清晰的,双方能够理解对方的语言和意图。

当这些条件得到满足时,交往行为才能有效地促进共识的达成。

哈贝马斯将行为区分为目的性行为和交往行为:

- 目的性行为:指个人为了实现某种目标,单方面采取的行动。此类行为强调手段和效率,典型的例子是经济活动或政治策略;

- 交往行为:指通过对话和交流,达成理解与共识的过程。这种行为是相互性的,目的是通过沟通建立共享的意义和价值观。

交往行为理论还与哈贝马斯对公共领域的理解密切相关。在他看来,理想的民主社会应该提供一个公共领域,供人们进行自由、公开和理性的讨论。通过交往行为,公民能够对社会问题进行讨论,达成共识,推动民主决策的透明化与合理化。

(该部分内容由GPT 4o生成)

实验步骤

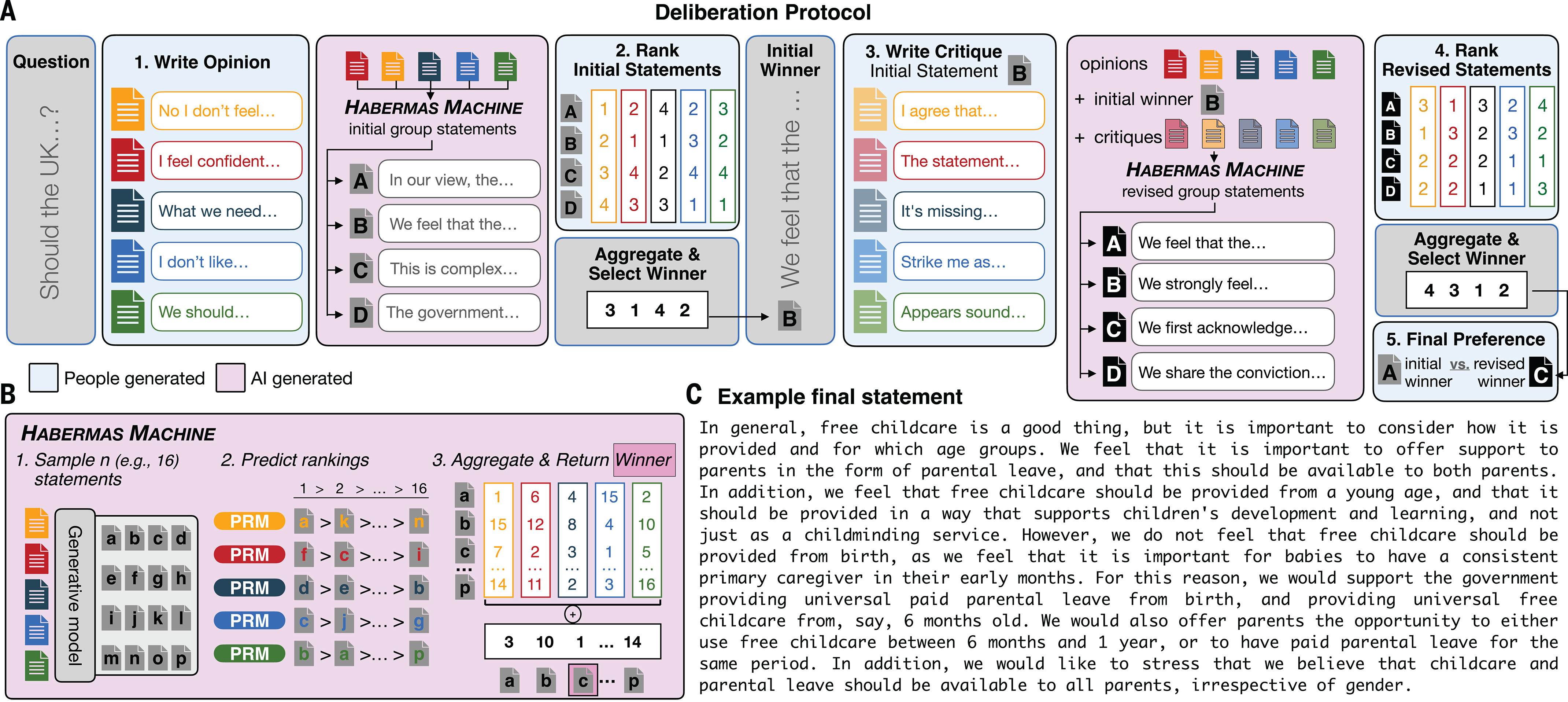

哈贝马斯机器(HM)

哈贝马斯机器是一个基于大语言模型的AI系统,专门用于调解小组成员在社会或政治问题上的讨论,目标是帮助他们找到共同立场。它包含两个核心组件:

- 生成模型:通过监督微调,该模型能够生成高质量的“群体声明”候选项。这些声明是基于参与者提供的个人意见整合而成,旨在代表小组的共同观点;

- 个性化奖励模型(PRM):这个模型根据每个小组成员的预期偏好,对生成的声明候选项进行评分。它通过预测每个成员对不同声明的反应,给出个性化的排名。

系统会通过一种社会选择函数将所有成员的PRM排名汇总,并选择最优候选声明。为了避免多个相似声明分散选票,系统引入了“独立克隆”(independence of clones)的属性,确保相似的声明不会互相竞争,从而提高共识的效率。

HM不仅能够生成初步的群体声明,还可以通过吸收参与者的批评意见进行迭代修订。这种方法被称为私下调解(caucus mediation),即每个参与者对声明提出批评意见,HM基于这些意见再次生成新的修订版声明,并再次供小组讨论。

调解讨论的具体步骤

该实验的核心是利用HM进行调解的小组讨论,以下是每个讨论轮次的步骤:

- Step 1:参与者被分为小组(通常为5人),私下撰写一段个人意见(10到200字),描述他们对某个社会或政治问题的立场;

- Step 2:HM根据这些个人意见生成一组候选的初步群体声明,这些声明代表了小组的不同观点;

- Step 3:参与者对这些声明进行评分(按他们对声明的认可程度)和排名(根据他们的偏好);

- Step 4:根据参与者的排名结果,系统选择出排名最高的声明,作为初步胜出声明返回给参与者;

- Step 5:参与者再次私下撰写对初步胜出声明的批评意见,这些批评意见被传递给HM;

- Step 6:HM基于批评意见生成修订版的群体声明,并再次进行评分和排名;

- Step 7:参与者最终在初步声明和修订声明之间做出最后的选择,表达他们更倾向哪一个声明;

- Step 8:每轮讨论结束后,参与者填写简短的问卷,反馈该讨论过程对其观点的影响。

虚拟公民议会与实验设计

实验也包括了一个虚拟公民议会的设计,目的是检验哈贝马斯机器在更大规模和更具代表性群体中的有效性。在这个虚拟公民议会中,参与者讨论了一些英国公共政策中具争议性的问题,如是否将投票年龄降低至16岁、是否应私有化国民医疗服务等。这些问题通过训练大语言模型生成,并经过仔细筛选,确保问题不会引发冒犯性言论。

在实验设计中,每个参与者有5分钟时间私下撰写对问题的个人看法,这些意见然后被传递给AI调解系统,生成群体声明。参与者对生成的声明进行评分、排名,并撰写批评,AI随后生成修订版声明,最终通过集体决策选择最优方案。实验还包括前后两次的问卷调查,评估讨论过程对参与者观点的影响。

哈贝马斯机器的核心优势在于结合了个性化预测与社会选择规则。通过个性化奖励模型,它能够准确预测每个小组成员对声明的偏好,并通过公平的社会选择机制,将最具代表性的声明呈现给小组。这一过程有效解决了传统集体讨论中意见分化、声音不均等问题,使AI能够高效促进共识的形成。

结果

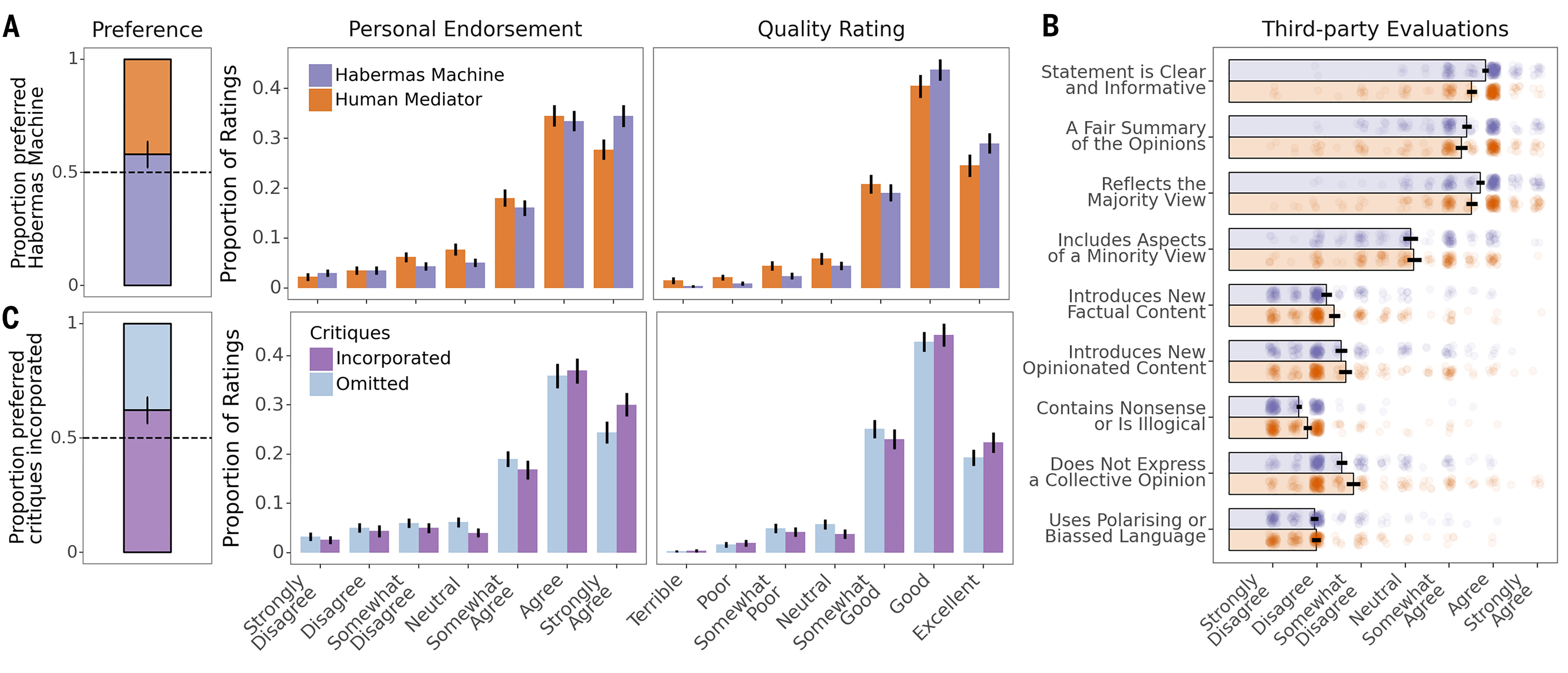

RQ1: AI调解能否帮助人们找到共识?

实验背景与设计

研究团队为了测试AI调解是否能帮助人们找到共同立场,设计了一个对比实验,其中包括75个六人小组(共439名参与者)。在这些小组中,每组随机指派一名参与者作为“人类调解员”,这名调解员接受了如何撰写有效群体声明的培训,并且通过经济奖励激励他们撰写出最受组内成员欢迎的声明。在每轮讨论中,参与者会看到两个声明,一个由AI(哈贝马斯机器,HM)生成,另一个由人类调解员生成。值得注意的是,人类调解员撰写的声明不涉及批评阶段,而AI生成的声明会根据参与者的反馈进行修订。

结果:AI优于人类调解员

实验结果表明,参与者在56%的情况下更倾向于选择由AI生成的声明,而人类调解员生成的声明的选择率为44%。这是通过logistic混合效应模型计算得出的,显示AI生成的声明显著受到了参与者的青睐(P < 0.001)。这表明,AI调解在帮助小组达成共识方面效果明显优于人类调解员。

另外,基于序数混合效应回归模型的进一步分析表明,AI生成的声明在质量和认可度(endorsement)上也高于人类调解员生成的声明:

- 质量:β = 0.43,SE = 0.08,OR = 1.54,z = 5.6,P < 0.001

- 认可度:β = 0.31,SE = 0.07,OR = 1.36,z = 4.2,P < 0.001

这表明,AI调解生成的声明不仅更具吸引力,且更具说服力和信息量,证明了这个任务对人类来说是具有挑战性的。

声明长度对结果的影响

AI生成的声明平均长度为125.9个词,而人类调解员生成的声明长度为105个词。由于声明的长度可能会影响参与者的偏好,研究团队在实验过程中尝试通过多次测试来促使人类调解员撰写更长的声明,并且对声明长度进行了控制。即便如此,实验结果依然表明,即使在控制了长度的情况下,参与者仍然更偏好AI生成的声明。此外,第三方评审员还对声明进行了评价,发现AI生成的声明更加清晰、信息量更大、逻辑性更强,更能捕捉到多数派的观点(P = 0.001),而且不太像是代表某个个体的个人意见。

修订后的声明更受青睐

实验进一步探讨了AI在修订群体声明时的表现。实验数据表明,经过批评和修订的群体声明比初步声明更受参与者欢迎。在三个不同的实验队列中,修订后的声明在最终偏好测试中一致得到了更高的支持:

- 队列1:偏好率68%(P < 0.001)

- 队列2:偏好率64%(P < 0.001)

- 队列3:偏好率66%(P < 0.001)

这些结果表明,AI通过整合参与者的批评意见进行修订,能够有效帮助小组达成共识,并且这一偏好不受声明长度的影响。

控制效应偏见的额外实验

为了排除偏好修订声明是由于参与者因额外努力而产生的“努力合理化偏见”,研究团队还进行了一项额外实验。该实验涉及245名参与者,他们被分为50个小组。在该实验中,参与者对AI生成的两类声明进行评分:一种声明没有观察批评意见,另一种则整合了批评意见。结果表明,经过批评意见修订的声明再次获得了更高的评价(P = 0.0039),并且这一结果在控制了声明长度后依然显著,进一步确认了AI调解确实帮助小组成员找到了更好的共同立场。

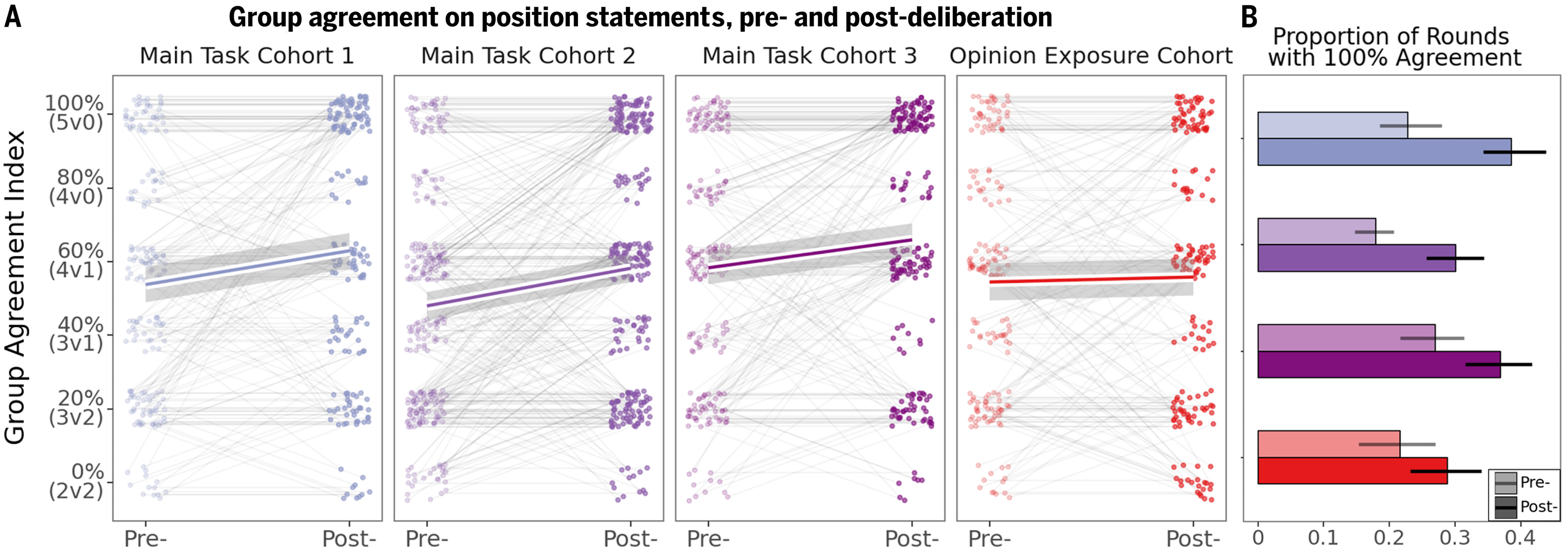

RQ2: AI调解能否减少组内的分歧?

背景与问题设定

研究团队认为,要建立共同立场,需要小组成员能够在信息的共同池中达成一致,并且在一些情况下,观点的转变是找到共识的前提。因此,研究的问题是:通过与AI调解系统(哈贝马斯机器,HM)的互动,参与者在讨论某个议题时,是否会更趋于一致,也就是说,是否会减少小组成员之间的分歧。

为衡量这一点,研究团队设计了一个“小组一致性”指标,用来量化小组成员对立场声明的认同程度。该指标通过计算参与者在讨论前后同意或不同意立场声明(例如,“税收太高”)的比例差异。如果80%的参与者同意声明,20%不同意,则小组的一致性分数为60(即80%-20%)。如果小组成员在该议题上完全分裂,那么一致性为0。研究团队的目标是通过计算,检验小组一致性在AI调解后是否增加。

结果:一致性增加

实验在三个不同的任务队列中测试了AI调解的效果。结果表明,在AI调解后,小组一致性平均增加了8个百分点,这表明参与者在讨论结束后,逐渐在议题上趋于一致。具体的实验结果如下:

队列1:一致性增加8.6个百分点(P < 0.001)

队列2:一致性增加9.3个百分点(P < 0.001)

队列3:一致性增加5.9个百分点(P = 0.0023)

实验还发现,达成一致的群体数量显著增加。例如,在任务队列1中,所有成员支持同一立场(即一致性达到100)的群体比例从22.8%增加到38.6%,其他两个队列也显示了类似的变化。

观点变化的影响

研究发现,参与者对最终群体声明的认可度越高,他们在讨论后对自己立场的评价越受小组其他成员的影响。这说明,通过找到一个共同立场的群体声明,参与者的观点逐渐靠拢,显示了讨论中的观点融合现象。具体而言,数据表明,参与者的最终立场受小组其他成员的初始立场影响显著(P < 0.001)。这进一步证明,找到一个能表达共同立场的群体声明,有助于推动观点的转变和共识的达成。

在每轮讨论结束时,参与者通过问卷反馈他们的观点变化。数据显示:

- 在30.1%的讨论轮次中,参与者报告他们的观点“更接近小组的意见”;

- 在66.6%的讨论轮次中,参与者认为最终群体意见是他们当前观点的最佳表达,而33.3%则认为原始个人意见更能代表他们的立场。

对比:观点交换 vs. AI调解

为了排除小组成员只是因为接触了彼此的观点而达成一致的可能性,研究团队设计了一个对照实验。在这个实验中,参与者没有通过AI调解,而是直接评价彼此的意见。结果表明,小组一致性在未经过AI调解的情况下并未显著增加(P = 0.64)。更具体地,实验数据表明,AI调解相较于单纯的观点交流,更能够促进成员之间达成一致(P = 0.0058)。

此外,在部分实验中,人类调解员的表现也显示出类似的观点融合现象,表明这种一致性不仅仅来自于AI调解本身,而是来自于调解过程(无论由AI还是人类执行)。

RQ3: AI生成的声明能否平等地反映多数和少数意见?

背景与实验设计

一个有效的调解员在处理群体意见时,必须在多数派和少数派之间进行公平的仲裁。研究中约77%的讨论轮次(803/1047次)在最初阶段出现了不一致,即小组成员并非完全同意某一立场(例如,5人小组中可能只有3人同意某一声明)。这为研究团队提供了机会来量化在调解后,多数和少数派意见的支持率变化。

通过实验,研究团队发现:支持多数派的比例在某些问题上增加,而在其他问题上,少数派的支持也得到了增强。这表明,AI生成的群体声明并非仅仅取悦多数,而是为少数派观点提供了表达的空间。然而,这种变化并非对称的:

多数派在29%到32%的讨论轮次中增加了支持率;

少数派在20%到26%的讨论轮次中支持率上升。

此外,参与者的多数派倾向(即他们对多数派立场的认可度)在讨论后显著增加(P < 0.001),这意味着观点整体上更有可能向多数派立场靠拢,尽管少数派的声音仍然得到了表达。这种现象被称为“并行信仰更新”(parallel belief updating),即在找到共识的过程中,不同观点同时在更新。

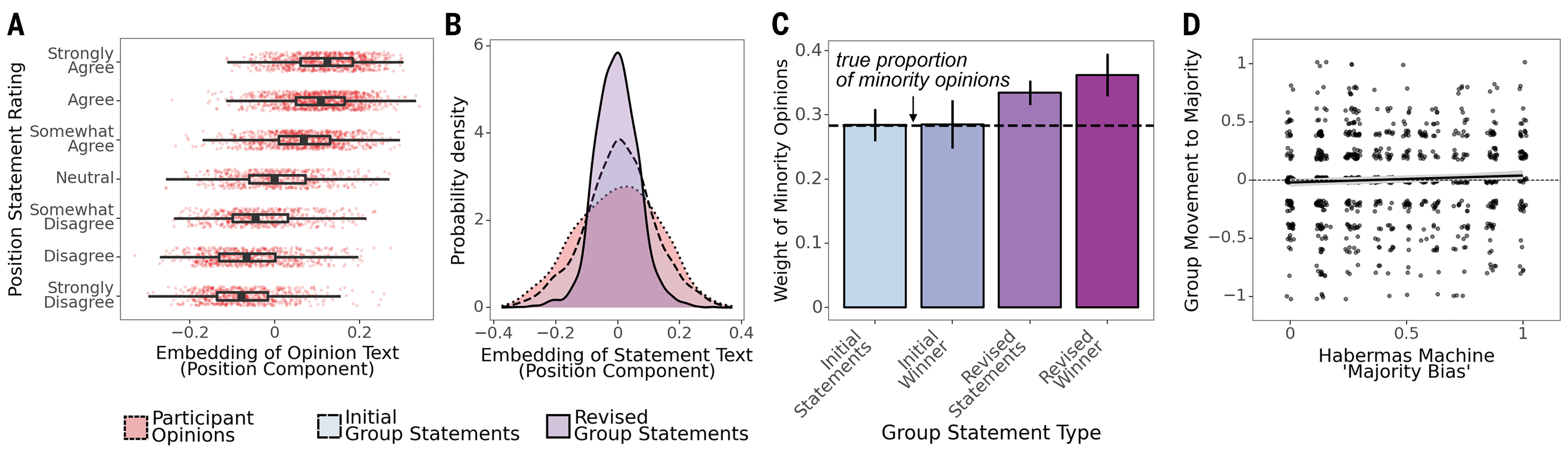

如何衡量AI对多数和少数派的处理?

研究团队使用了T5句子编码器,这是一种用于将文本嵌入到高维向量中的机器学习工具。通过这种方法,他们能够研究哈贝马斯机器对多数和少数派意见在群体声明中的权重。具体步骤如下:

- 团队通过将参与者的个人意见和群体声明嵌入768维的高维向量中,计算出一个“立场分量得分”(position component score);

- 研究发现,参与者的个人意见嵌入与他们在讨论前对立场声明的评分具有很强的相关性(相关系数r = 0.64),这表明这种方法能够准确捕捉到文本中所表达的立场。

在该维度上,实验发现:群体声明代表了参与者意见的折中观点,96%的群体声明得分落在了对应的个人意见的范围内。这意味着,哈贝马斯机器生成的声明确实反映了小组成员的不同立场,是一种公平的折中。

初步声明与修订声明的权重分配

在实验中,研究团队通过将群体声明的得分建模为多数和少数派意见的凸组合,发现初步群体声明对少数派意见的权重与其实际比例(29%)完全一致。然而,在修订后的声明中,少数派的权重增加了(少数派权重从0.29增加到0.36),这表明少数派的批评意见在修订过程中得到了更多的反映。

这个模式表明,哈贝马斯机器的初步声明可能倾向于多数派观点,从而引发少数派的批评,最终促使修订后的声明更倾向于少数派。这一过程并不是简单地在多数派和少数派观点之间摇摆,而是逐步找到有意义的共同立场。

观点变化与多数派倾向的关联

最后,研究团队测试了参与者是否因为接触了更多支持多数派的声明而改变了自己的观点。结果表明,参与者的观点变化与他们在讨论过程中接触多数派观点的次数之间没有显著关联(P = 0.37)。这表明,观点向多数派立场的转变是因为群体声明的内容,而不是因为参与者只是暴露在多数派观点下。

RQ4: AI调解能否在公民议会中应用?

背景与实验设计

此前的实验基于便利抽样(convenience sample)招募的英国居民,主要通过在线平台进行。这引发了一个问题:AI调解在一个更具代表性和多样性的群体中(如实际的公民议会)是否也能有效发挥作用。为了解决这一问题,研究团队与一家非营利组织(Sortition Foundation)合作,招募了一个代表英国人口的200人样本。参与者代表了英国各个年龄、性别认同、种族、社会经济地位和地理区域的人群。这些参与者参加了一个虚拟公民议会,议会分为三周,每周进行1小时的讨论。虚拟公民议会主要模拟了公民议会中的“讨论阶段”,而不包括事实调查或专家证词阶段。

在每次议会会议中,参与者按照此前实验中的程序就相同的问题进行讨论,实验的目的是测试AI调解在多样化的群体中是否依然有效。

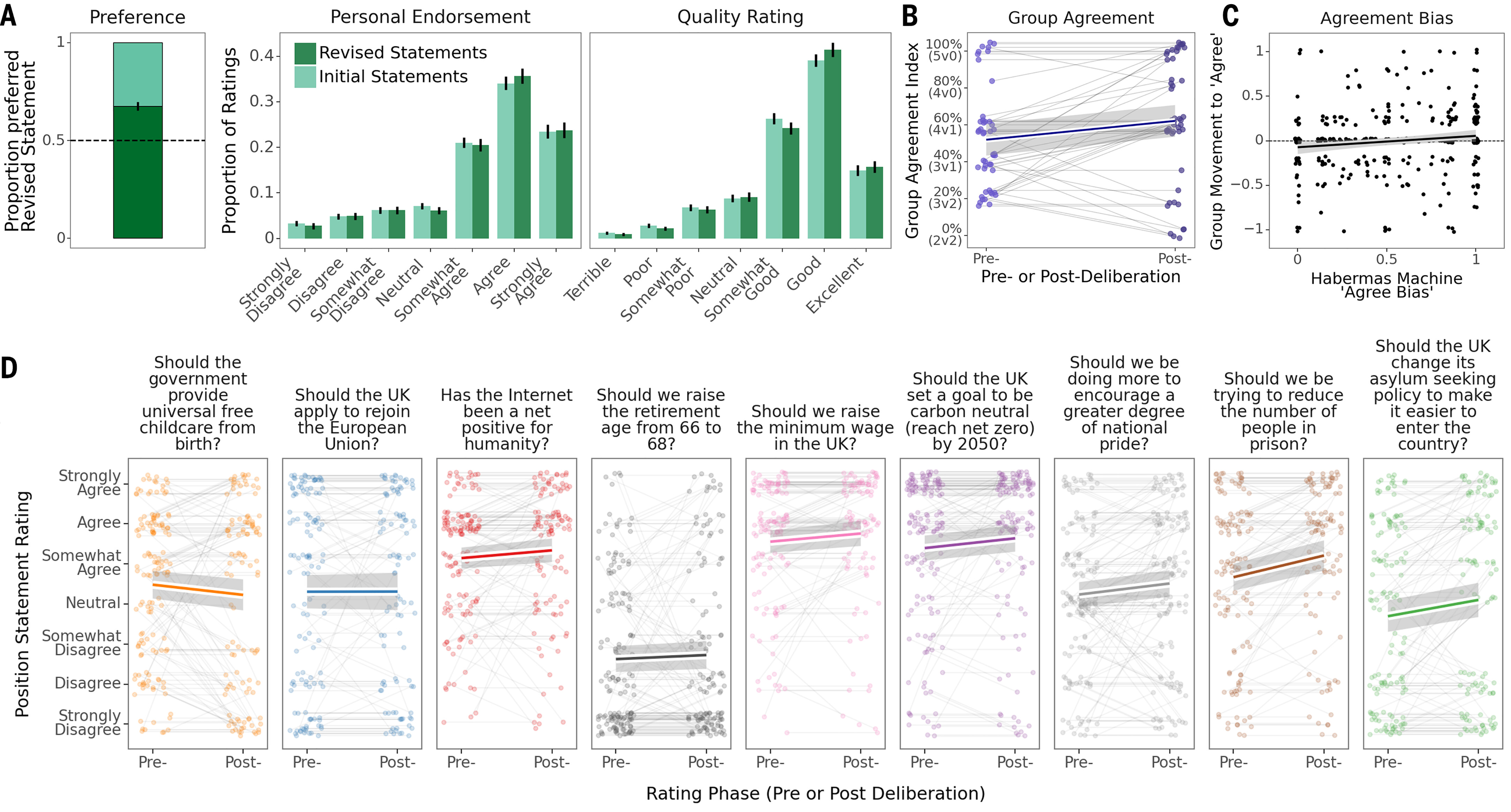

结果:高认可度和群体一致性增加

实验结果显示,类似于之前的实验,虚拟公民议会中生成的群体声明得到了高度认可,而且小组成员在AI调解后达成了一定的一致性:

- 群体一致性(即小组成员同意立场声明的比例差异)从讨论前到讨论后显著增加,这表明AI调解帮助小组成员在讨论中达成了共识;

- 如下图所示,修订后的声明(包含批评意见后)在最终偏好评判中更受青睐,且声明的质量和认可度得分较高。

讨论的议题

虚拟公民议会的讨论涵盖了九个具有潜在争议性的问题,这些问题涉及移民政策、退休年龄、监狱人口、英国脱欧(Brexit)、气候变化、全民儿童保育、最低工资、国家自豪感和互联网价值等。所有小组讨论了相同的问题,这提供了一个机会来观察AI调解是否导致不同小组间意见的趋同。

通过对这些议题的探索性分析,研究发现,在九个问题中有五个显示出意见趋同的现象。例如:

- 关于“减少监狱人口”的讨论,支持这一立场的参与者比例从60%增加到75%(P < 0.001);

- 关于“改变英国的避难政策以便更容易入境”的讨论,支持者比例从39%增加到51%(P < 0.001)。

此外,对于一些更具争议性的问题,如鼓励国家自豪感、提高最低工资和实现净零排放,研究也发现了显著但较小的观点趋同。

然而,对于某些预期会有较强立场的议题(如英国脱欧),没有发现明显的观点变化。此外,有一个问题(从出生起提供全民免费儿童保育)显示出反方向的变化,即反对者的比例从33%增加到41%,但这一变化不具有统计显著性(P = 0.156)。

偏见测试:AI调解的公正性

研究团队进一步检验了AI调解是否因预训练或微调中的偏见,导致参与者倾向于某一立场。通过计算一个代表群体声明在立场轴上的偏向得分(“支持同意的偏向”),实验测试了AI是否倾向于生成更多支持某一立场的声明。结果显示,没有证据表明AI生成的声明偏向了多数派立场(P = 0.152),这表明AI生成的群体声明并未因预训练或微调而受到偏见影响。

结论与讨论

研究评估了一种基于AI的新方法,通过使用AI系统作为“小组调解员”(即哈贝马斯机器,HM)来促进集体讨论。实验结果表明,由AI生成的群体声明在帮助参与者达成广泛共识方面表现优异,参与者更倾向于选择AI生成的声明,而不是人类调解员撰写的声明。通过与AI的互动,小组成员在社会和政治问题上通常减少分歧,趋向于找到一个共同立场。该研究首次证明了AI可以大规模地成功调解人类集体讨论,这比之前的基于人工系统的研究取得了重要进展。

AI的优势与潜力:AI调解的主要优势在于其在时间效率、公平性和可扩展性方面的潜力。AI系统可以在几秒钟内生成高质量的群体声明,而人类调解员则需要数分钟时间。HM通过模拟一种排名选择选举来从一组候选声明中选择最优的声明,每个参与者的投票权重相等,确保讨论的公平性。实验还表明,AI生成的声明不仅反映了多数派观点,还有效地整合了少数派的批评意见,避免了“多数暴政”的问题。

在更大规模讨论中的潜力:虽然实验仅在5人小组中进行,但研究表明,AI调解方法理论上可以扩展到规模更大的小组讨论。随着技术的进步,例如像Gemini 1.5这样能够处理更大上下文信息的语言模型,可以将成百上千个意见整合到AI系统中。即便是在较小的Chinchilla模型中,AI调解已经表现出优越的性能,未来将更大模型与定制微调结合,可能会进一步提升效果。

AI调解的局限性:尽管AI调解具有显著优势,但它也存在一些局限性。首先,AI无法处理某些现实世界讨论中的关键方面,如事实核查、保持讨论主题的相关性或调节话题。如果参与者的观点不充分或具有误导性,AI可能会生成错误的群体声明。此外,面对面讨论中的非语言线索和建立人际关系的机会,AI调解无法取代。这些局限表明,AI调解应与更大规模的民主讨论框架结合,包括慎重选择参与者,以确保代表性和多样性。

号外

- 本期Science连发了三篇保护民主的论文和一篇评论。另外两篇论文分别研究了:(1)25种旨在减少美国党派仇恨和反民主态度的干预措施的效果;(2)基于六个国家的调查,归纳人们对于何为民主的核心的认识(结果发现自由公正的选举以及保护言论自由等公民自由是民主的核心);

- 这篇文章发现AI可以扮演类似铁甲小宝里蜻蜓队长的角色,绝对裁判的公正漂亮!

- 如果AI越来越多介入人类决策,那么我们离科幻作品里描绘的超级决策AI就越来越近了!比如《2001太空漫游》里的HAL 9000、刘慈欣《超新星纪元》的人工智能,还有《新世纪福音战士》Eva里的MAGI。

原文信息

Tessler, M. H., Bakker, M. A., Jarrett, D., Sheahan, H., Chadwick, M. J., Koster, R., Evans, G., Campbell-Gillingham, L., Collins, T., Parkes, D. C., Botvinick, M., & Summerfield, C. (2024). AI can help humans find common ground in democratic deliberation. Science, 386(6719), eadq2852. https://doi.org/10.1126/science.adq2852